chaîne de Markov

Français

Étymologie

- D’après Andreï Markov.

Locution nominale

| Singulier | Pluriel |

|---|---|

| chaîne de Markov | chaînes de Markov |

| \ʃɛn də maʁ.kɔf\ | |

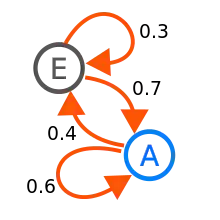

Exemple élémentaire de chaîne de Markov, à deux états A et E. Les flèches indiquent les probabilités de transition d’un état à un autre.

chaîne de Markov \ʃɛn də maʁ.kɔf\ féminin (orthographe traditionnelle)

- (Probabilités) Représentation de la prédiction du futur grâce à l’état présent du processus.

Variantes orthographiques

Dérivés

Traductions

- Anglais : Markov chain (en)

- Italien : catena di Markov (it)

Prononciation

- France (Toulouse) : écouter « chaîne de Markov [Prononciation ?] »

- Lyon (France) : écouter « chaîne de Markov [Prononciation ?] »

Voir aussi

- chaîne de Markov sur l’encyclopédie Wikipédia

Cet article est issu de Wiktionary. Le texte est sous licence Creative Commons – Attribution – Partage à l’identique. Des conditions supplémentaires peuvent s’appliquer aux fichiers multimédias.